11/16に行われた 第4回新ROBO-剣に参加しました。ロボットは去年と同じ「逡巡」です。

結果は本戦トーナメント2勝1敗、敗者トーナメント(本戦で早めに負けたチームによる別リーグ)第2位でした。新ルールでは、今回初めて有効な攻撃で勝利を挙げることができました。勝利した試合はすべてストレートの2本先取となっており(1本取った後に電源が落ちてタイムを取得したことによる反則のみ1回あり)、安定した動作ができるようになってきたと思います。

#ROBO剣

— 山口辰久 (@qzy13700) November 16, 2025

「逡巡」の成績は本戦2回戦敗退、敗者トーナメント2位でした。

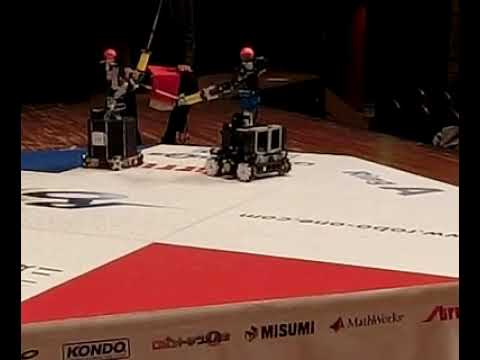

映像は敗者トーナメント1回戦のCupidと。回転攻撃を避けて退いているかのように見えて面白いのですがそうではなく、相手重心位置が近づいたのでそれに合わせて下がっただけです。また、攻撃ではなく探索動作だと思われます。 pic.twitter.com/BoUBQKGGZg

今回の変更点としては、システムの信頼性を向上させ、また開発途中だった部分を完成させ、前回できなかった動作をできるようにしたということになります。

特に、「移動しつつアームの動作を開始して、アームの届かない範囲から攻撃を行う」という動作も部分的に実現し、試合のアルゴリズムにも組み込んで実際に有効打突を取ることができました。「部分的に」というのは、予め進む距離を固定値(25cm)で与えてあり、この分アーム原点をずらして打撃成功する軌道が作れたら採用する、となっている点です。本来は踏み込む距離も逆運動学の変数に入れて解くのが綺麗なのではないかと思います。

#ROBO剣

— 山口辰久 (@qzy13700) November 9, 2025

一足一刀あるいは遠間からの打撃。

6月に足回りの制御を改善したので以前より多少信頼性が上がったと思います。知能ロボコンはで停止位置の精度優先でしたがこの動きのためには加速度と速度を上げる調整をしていくことになります。

実際の試合で使えるかどうかはわかりません。 pic.twitter.com/C6CXiP6dsq

試合のアルゴリズムは大まかには、次の3つを常に行います。

1. 相手の方を向く

2. 相手との距離を保つ

3. 有効打突部位が打てそうな状態であれば打つ

またこれらと並行して、フィールド外周から落ちないように、縁に近づいたらその近さに応じて中央方向に戻す速度ベクトルも加算しています。現在位置の認識はIMUと独立計数輪で測った移動距離をスタート地点から積算するのみとなっています。ROBO-剣のルールであれば試合時間の3分程度は誤差も許容範囲に収まると読んで設計した方法でしたが、今回実際にそれが証明されました。

特に敗者トーナメントの決勝戦では、相手ロボットはアームの届く距離まで接近しようと近づいてくる一方で逡巡は踏み込んでの打撃に適した距離を保とうとし、結果的にフィールドの周りを回りながら3分間ずっと追いかけっこ(後ずさりで逃げる側)しつつの攻防が繰り広げられる、という格好になりました。次第に誤差によりリング縁に寄っていき最後は車輪のうち1つがリングから脱輪したもののそのまま復帰し、時間一杯まで動作を続けました。

上記のような刺激反応系のreactiveな部分しかできていないため、この例もそうですが、相手によっては膠着状態になってしまうことがあります。せっかくマップ上での自己位置という大局的な情報が使えていてこれは優勝ロボットにもないものなので、次はこれを活かして相手の横に回り込む、追い詰める、等といった戦略的な部分も実装したいと思います。

また、基礎となる制御的な面で改善点というかまだ実現していない点になりますが、次は移動している標的にも当てられるようにしたいと思います。

これは、現在は相手が止まっているものとして動いているため、動き回り続ける相手にはなかなか当たらない、というよりも原理的に当たらない、という状態になっています。テーブルホッケーロボットと同様に対象物体の移動履歴からの外挿による行き先予測を使えばひとまずできるのではないかと考えています。

実はこの逡巡でも既に一度作ったことがあったのですが、当時は固定型アームだったため、相手も直線的な予測しやすい軌道では動かない上、外挿はノイズを増幅するため誤差も出やすい、ということで保留していました。移動型の新ROBO-剣では効果の方が勝るかもしれません。

十分な効果を得るには対象物の位置計測の精度と、全体的な処理速度の向上も必要となります。3次元点群を入力とする処理をしているので処理量が多くなりがちで、現状では毎秒7〜15回ぐらいとなっていました。これを改善するのが次の課題となります。

優勝した「メタリックファイター」は毎秒30回のビデオフレームレート内で処理が終わるようにという縛りをソフトウェア設計に入れており、単純なラスタ画像(深度)の処理で相手の認識を行っている、処理対象データもなるべく減らしている、とのことでした。逡巡ではガードをかわしての打突(防がれるような打ち方はしない)ということも目指しているので3次元点群を対象とする処理という方式は変えないと思いますが、この30fpsを目安として少しでも近づけるように今後処理の方法を考えていくことにします。